近日,我院青年博士陳燚雷在《電子學報》發表論文《基于語義增強與紋理-運動融合的說話人無關視覺配音方法》。

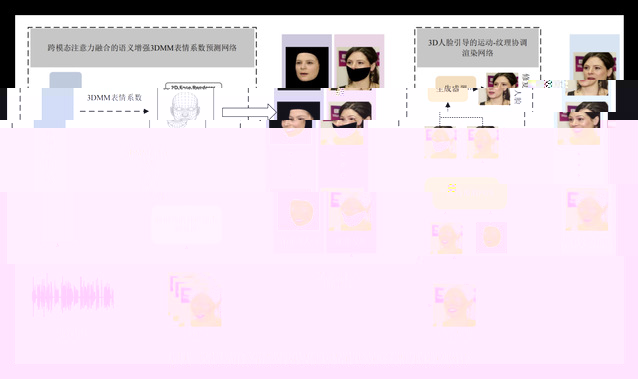

研究圍繞真實場景視覺配音難題,提出以“運動-紋理協同融合”驅動的高保真生成框架,為複雜頭動條件下的自然口型合成帶來新突破。團隊指出,傳統視覺配音在頭部轉動、側臉或遮擋時易産生唇周紋理模糊與修複不連續的“補丁感”。為此,論文引入3D可變形人臉模型作為中間表示,将任務分為“語音驅動三維表情運動預測”和“運動引導紋理生成渲染”兩階段:先讓人臉運動精準可控,再用運動信息反向約束紋理補償,從源頭提升幾何一緻性與紋理真實度。研究的核心創新在運動與紋理的聯合建模,渲染階段通過語義引導的運動流場實現全局非剛性對齊,确保跨姿态下“動得對”;随後運動感知紋理調制模塊在流場約束下調制多尺度紋理特征,把運動結構直接轉化為紋理生成先驗,穩定恢複嘴唇與唇周高頻細節;再結合多參考紋理與自适應融合,兼顧全局運動一緻與局部細節自然過渡。實驗表明,該策略顯著提升紋理清晰度與穩定性,并在VoxCeleb1/2等數據集上全面優于現有方法。

該工作展示了“運動融合促進紋理生成”的有效路徑,為虛拟人、影視配音、本地化傳播與在線教育等應用提供了更可靠的技術支撐,并有望在數字金融領域的智能客服、虛拟櫃員與沉浸式業務宣介中發揮賦能作用。(撰稿:陳燚雷 審核:李睿恒)